どんなサウンドにも思い入れがあることこそ大事だと思う

音というのは後で幾ら手を加えても生き返りはしないんだ

アンディ・トーマ(写真左)とヤン・エスティー・ヴァーナー(同右)の電子音楽デュオ=マウス・オン・マーズ。1993年の結成以来、アンビエントやダンス・ミュージック、IDMなどの要素を感じさせる自由奔放なサウンドを展開し、2011年からはベルリンを拠点にプロダクションを行っている。2018年のアルバム『ディメンショナル・ピープル』でシカゴの名門レーベルThrill Jockeyへカムバック。この2月にリリースした最新作『AAI』では自主開発のAIソフトウェアをナレーションの生成に活用するなど、斬新な取り組みを見せている。また、アフロ・ビートのようなリズム・ワークや高解像度かつ特異な質感のサウンドも興味深い。2人のメンバーがプライベート・スタジオのParaverseからオンラインで答えてくれたので、その一部始終をお伝えしよう。

Text:Tsuji. Taichi Interpretation:Yuriko Banno Photo:Guillaume Bog(Portrait)

話し方をモデリングしてアルゴリズム化

それをAIによって発展させていく

ーなぜ実際のナレーションを録音せず、AIソフトに語らせようと思ったのですか?

アンディ “情報を入力して、そこから学ばせるもの”がAIだけど、欧米の資本主義的な観点で利用されることが多く、文化的な使われ方があまりされていないと感じていたんだ。つまり権力や情報の獲得のためではなく、それ以外の目的に使えないものかと考えていた。で、ラニー・ケドとデレク・ティングルという2人のプログラマーと組んでソフトを開発し始めたんだ。その後、BIRDS ON MARSなるベルリンの会社と出会い、さらに開発が進んだ。僕らの名前とそっくりの会社だ。結果的に出来上がったのはWebブラウザーで使用するソフトウェアで、声や文章を読み込ませてサウンドを生成するというもの。やがて曲作りに取り入れる機会が増え、アルバムに多用することとなった。

ー誰の声を読み込ませて使ったのですか?

アンディ まずは作家で学者のルイス・シュデ=ソケイ。彼はAIに関する文章を書いてもくれて、声とともに読み込ませた。それからBIRDS ON MARSのプログラマーで、今回のソフトのプログラミングにも携わったヤムア・ウツコンカヤ。アルバムに使ったのは、この2人の声だね。

ーソフトの構造について伺います。ナレーションのサンプルをプレイバックするものなのか、入力した音声情報と文字情報を組み合わせて自由にナレーションを作成できるものなのか、どちらなのでしょう?

ヤン 後者だね。ナレーションだけでなく歌のようにすることもできるし、声音を変えることだって可能だ。僕たちが目指しているのは“声の楽器”だからね。開発においては、まず“特定の話し方をモデリングしてアルゴリズム化する”というプロセスがあった。そのアルゴリズムは入力されるさまざまな情報から学習するので、ソースの声にどんどん近付いていく。“さまざまな情報”というのは声の音、その声が特定の言葉をどう発音しているかなど。さっき話した通り、AIに学習させるには情報の入力が必須なんだ。

ーたたき台となるアルゴリズムを作ってから、よりパーソナルな情報をAIに与えることで、アルゴリズム自体をアップデートさせていくような仕組みですね。

ヤン 難しかったのは、入力した声がどんな音として聴こえるのかを定義すること。デジタルの世界では、形がまだ定義されていないものが存在しているんだ。つまり遺伝情報が先にあって、その一方で“もの”がどういう形で存在するのかを定義しなければならない。プログラマーにとっては幾らでも時間を費やせる部分で、いたずらに時が過ぎる場合もあれば抜け道を見付けることも可能だ。BIRDS ON MARSのメンバーは、その抜け道を発見するのがうまかった。

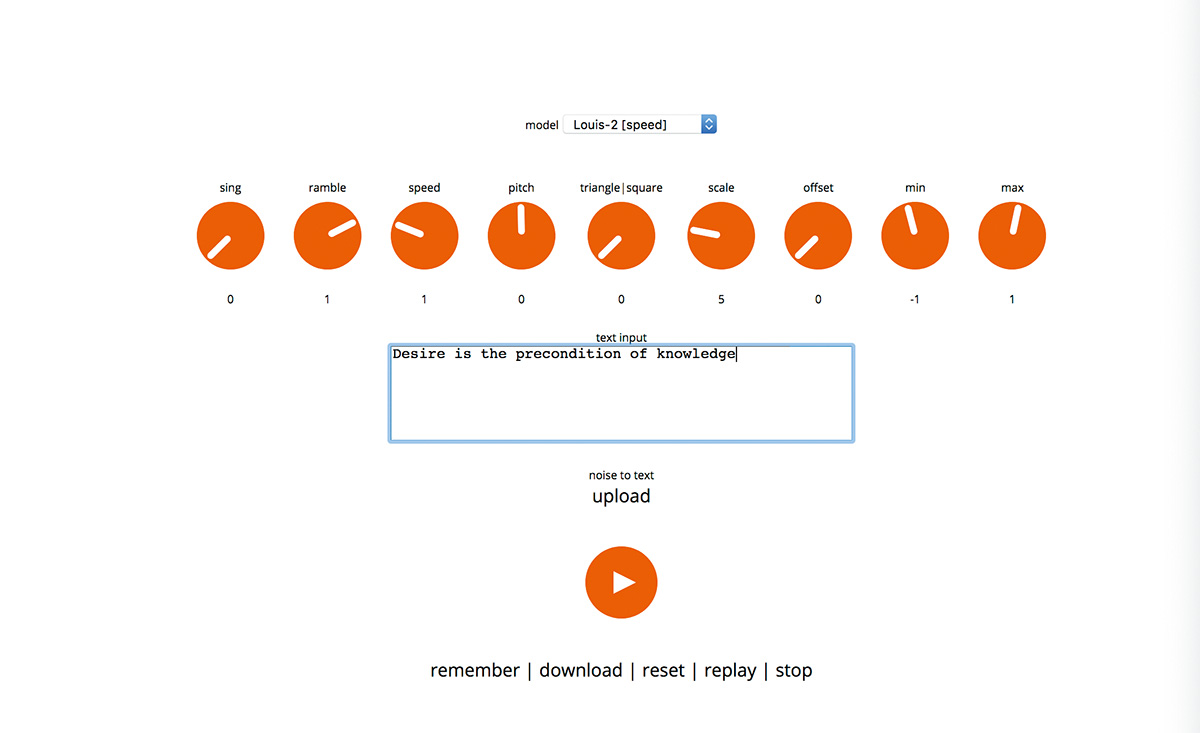

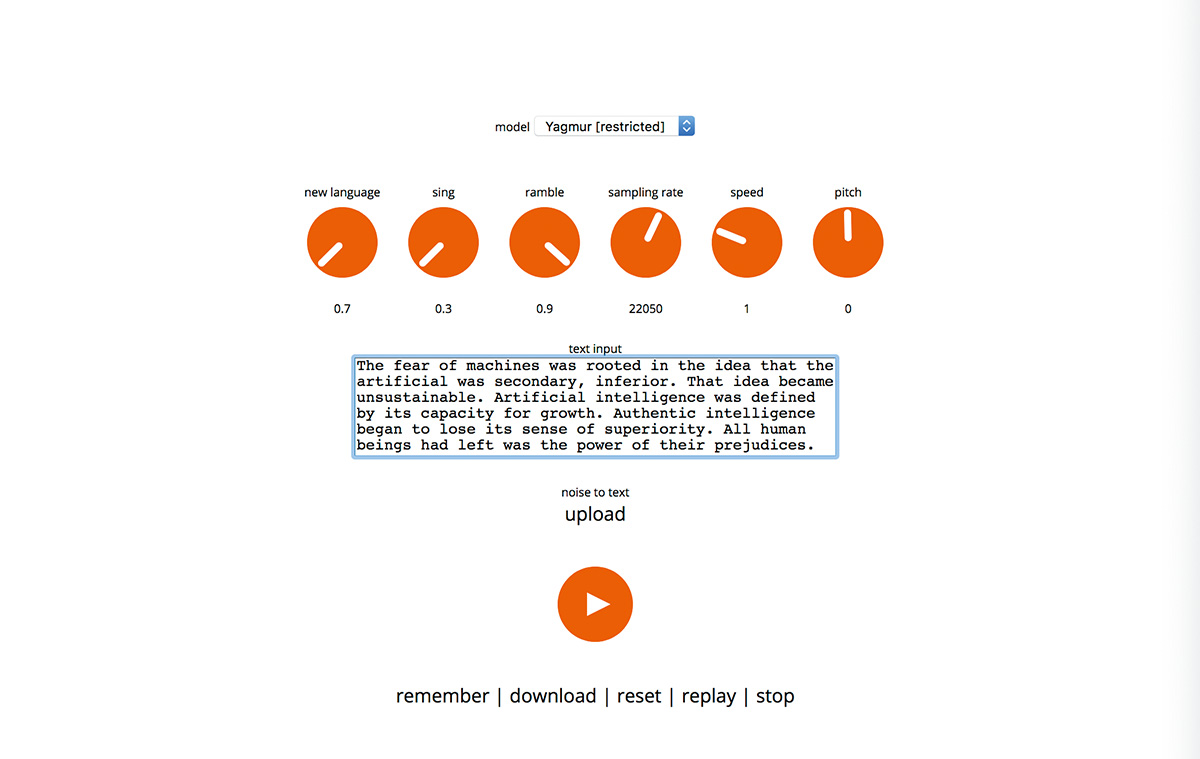

ーソフトには、どのようなユーザー・インターフェースが用意されているのでしょう?

ヤン 複数のノブを備えていて、例えばramble(取り止めもなく話す)、sing(歌う)、speed(モジュレーション・スピード)といったものがある。

アンディ new language(新言語)というノブをひねると酔っ払ったような声になる。それからsampling rate。現状はこのくらいだけど、新しいパラメーターの追加も可能だ。あと、声だけでなく楽器の音を入力することもできる。

ヤン 使い方の手順としては、Webブラウザーを開いてから話してほしい言葉をタイプ・インし、パラメーターを調整する。再生ボタンを押すとデータがサーバーに送られ、数秒で結果が戻ってくるので、オーディオ・ファイルとして保存するかパラメーターの設定をやり直すか決めるんだ。面白いのは、同じ言葉を全く同じセッティングで処理しても、結果が常に違うこと。AIが毎回、新しく再計算をしているからだ。だから逐一ファイルを保存しておいて、曲に採用するものを後から選んだ。

ー往年のアナログ・シンセのように、その時々で出音が変化するのですね。

ヤン そうだね。面白い例えかもしれない。僕たちは、このソフトを一面的なものとしてはとらえていないんだ。プログラムそれ自体、ルイスの声、ルイスをソフトウェア化するという試み、出来上がったソフトを通してのルイスとのコミュニケーション……さまざまな要素から成り立っていて、無限の可能性がある。つまり、何か決まったことしかやらないツールだとは思っていない。そこが最も重要だ。

サンプリング周波数の違う音を同居させ

“解像度ごとの質感”を生かす

ーAIソフトによるナレーションのほか、アフロ・ビートを思わせるリズム・ワークが印象的です。ヨーロッパでトレンドとなっているアフロ・ハウスのムーブメントなどとも関係があるのでしょうか?

アンディ アフロ・ハウスとは全く関係が無い。確かに、ポリリズムを使うとアフロ・ビートっぽく聴こえるのは分かるよ。でもアルバムにはアラビックなビートも取り入れているし、それもまたポリリズムなんだ。あと、日本のdrumnoというバンドからもヒントを得た。彼らのドラミングには、アフロ・ビートなどとは違う日本的なグルーブを感じたんだ。だから今回、ポリリズムをより深く掘り下げたかったのは事実だね。さらに、ドラマーのドド・ンキシもポリリズムの可能性や構成の仕方を追求していた。ただし“今回はポリリズムをフィーチャーするぞ!”と意気込んでいたわけではなく、曲を作る中で自然とそうなったんだ。

ー曲作りは、どのような環境で?

アンディ アレンジはAPPLE Logic Proで行っていて、オーディオI/OはUNIVERSAL AUDIO Apollo。そのアウトプットをSOUNDCRAFTのアナログ卓DC2020へ立ち上げてミキシングしている。このDC2020は、DOC ANALOGという会社にモディファイしてもらったものでね。すごく良い音なんだ。

ヤン EQがオリジナルとは大きく違う。サンO)))のステファン・オマリーとPitaことピーター・レーバーグのプロジェクトがここでニュー・アルバムを制作したので、彼らの作品からも卓のオープンかつ温かみのあるサウンドを聴き取れるだろう。あと最近、デイヴィッド・グラブスと共同制作したばかりで、この卓を使ったらリッチでオーガニックなサウンドになった。ほかには無い音なんだ。

アンディ DC2020には、Logicからサンプリング周波数48kHzのサウンドを立ち上げている。物理的な操作子を扱えるし、ミックスのリコールはできないけれど、僕らはそれを望んでいない。普段はNEUMANN KH 310 AとWESTLAKE AUDIO BBSM-12でモニタリングを行っていて、卓のアウトを96kHzでプリントしている。

ー曲作りの手順を教えてください。

ヤン 加工済みのエレメントを無数にため込んでいるので、そこから選んでアレンジしていく。例えば「ユーマシーン」は声のパートから着手し、ドラムやベースを加えた後でアクセントになる要素を足した。「アーティフィシャル・オーセンティク」も声……“What are you?”“Artificial Authentic”といったナレーションから始めて、あとは大抵iOS用のシンセ・ドラム・アプリElasticDrumsで作った。僕らのブランドMOM INSTRUMENTSの製品で、現在はアップデートの準備中でね。新しいバージョンには『AAI』で使ったサウンドを含むキットも含まれる予定だ。

ーどの曲も、一つ一つの音の解像度が非常に高いと感じます。何か工夫していることはありますか?

ヤン 経験を積むうちに上達した部分も多いんだけど、例えば同じ周波数帯域に音を入れ過ぎないようにしたり、コンプレッサーやエンハンサーを単一のトラックにあまり使わないようにしたり……友人から学んだことの一つに“イコライジングだけでミックスをクリアに保つ”というのがあるんだ。丁寧にEQをかければ、それぞれの音の間にスペースを作ることができる。あと、僕らが気に入っているのは“解像度ごとの質感を生かす”ということ。例えばAIソフトではサンプリング周波数を調整できるので、生成されるファイルが22kHzだったり48kHzだったりとまちまちでね。でも、解像度の異なる音を組み合わせるとトータルの音像が豊かに、そして有機的になるんだ。キックやベースのように作り込まれた音もあれば、きめの粗い音もあるわけだけど、すべてに固有の味があって、それらをアナログ卓へ通すから一つ一つに十分な空間を持たせることができる。

すべてをグリッドに合わせなくても

それぞれが固有の時計で鳴っていればいい

ーキックが話題に上りましたが、ドラムのプロダクションについて教えてもらえませんか?

アンディ ここには良いライブ・ルームがあるから、キットを設置してオーバーヘッドにリボン・マイクを立てたりして録音した。そのキットが面白くて、キックはオーソドックスなものなんだけど、タムの代わりに裏側のヘッドが無いスネアを使ったりしたんだ。録り音に対してはEQをかけたくらいで、あまり手を加えていない。

ヤン ただし切り張りはよくやった。録り音をスライスしてワンショットやフレーズ・サンプルにし、それらを組み合わせてドラム・トラックを構築したんだ。あと、NONLINEAR LABSのデジタル・シンセC15で演奏したリズムも使っている。C15は、NATIVE INSTRUMENTSの創設者でReaktorの生みの親でもあるステファン・シュミットが新たに開発したもので、何とMIDIに対応していないんだ。だから自分たちの手で弾くしかないわけだが、そこは今回こだわった部分でね。人間の脳というのは、常に何かとのつながりや同期を求めている。だから僕たちミュージシャンが“音をシンクさせること”に躍起にならなくても、音楽は成立するんだ。テクノでは、すべてが同じ時計で完ぺきに同期されていることが多い。でも僕らは、全要素が固有の時計とリズムの物差しを持っていてもいいと考えている。

アンディ だからこそ、ドラムをLogic Proに打ち込む場合はマウスを使わないんだ。MIDIキーボードをドラム・キットの代わりに演奏して、より感情を込める。打ち込んだ後にクオンタイズすることもあるけれど、多くの場合、グルーブというのは実際に弾いたものから生まれるんだ。

ヤン かつては僕たちも、完ぺきに同期された音楽を作っていたことがあった。でも、どれだけ一生懸命にすべてを合わせようとしても、何かがズレているように感じてしまう。それが何なのかは分からない。超現実的な感覚だ。頑張っても合わせられないんだったら、逆をやってみるしかない。

ミックスがめちゃくちゃなのに

マスタリングをアテにするのはお門違い

ーマスタリングは、どなたが手掛けたのでしょう?

ヤン ジーノ・ミコライだ。彼は僕らと同じビルにスタジオを持っている友人でね。ミキシング中にやって来て“既に完ぺきなサウンドだ。この調子でやってくれたら、僕の仕事はすごく楽になる。細部にだけ専念すればいいからね”と言ってくれたんだ。すごくうれしかったよ。ミックスがめちゃくちゃだって話はよくある。マスタリング・エンジニアに渡して良い音にしてもらいたいという話もね。そういう手合いは口をそろえて“ラジオでも、ラップトップでも、PAシステムでも格好良く聴こえるようにしてほしい”と言うんだ。そんなの不可能に決まっている。

アンディ AIにマスタリングを頼んだ方がよさそうだね。

ヤン 最近はネット上にAIを使ったマスタリング・サービスがあって、それを利用する人も多いらしい。“ゴリラズの最新作みたいな音にしたい”などと考えて、リファレンスも一緒に送るんだ。するとAIが“リファレンスよりも200Hzが多いからカットして、50Hz以下は何もしなくて……”といった具合に処理していく。そこまで行くと違和感があるよね。どんなサウンドにも思い入れがあることこそ大事だと思うんだ。だからこそ、ドラムを録る部屋の響きから録り方、シンセに対する処理まで細心の注意を払う。オーバー・コンプやひずませ過ぎは良くないし、ヘッドルームが大切。音というのは、後で幾ら手を加えても生き返ることはないからね。

ー読者への素晴らしいメッセージだと思います。

ヤン 今は世界中が大変な状況だよね……。その中で音楽がどれだけ役に立つかは分からないけど、忘れちゃいけないのは全員が同じ状況下に居るということ。それは、皆が地球上に生きる者としてつながっている何よりの証だ。実感するのは難しいかもしれないけど、僕らが心に留めておくべき最も大事なことだと思うよ。

Release

『AAI』

マウス・オン・マーズ

Thrill Jockey/HEADZ(THRILL-JP 53/HEADZ 250)

- エンジニアリング・システムズ

- ザ・レイタント・スペース

- スピーチ・アンド・アムビュレイション

- サウザンド・トゥ・ワン

- ウォーキング・アンド・トーキング

- ユーマシーン

- ダブルキーロック

- マシーン・ライツ

- ゴー・ティク

- ザ・フィア・オブ・マシーンズ

- アーティフィシャル・オーセンティク

- マシーン・パースペクティヴ

- カッツ・ザット・フィッシャーネット

- トゥールズ・ユーズ・トゥールズ

- ルース・トゥールズ

- セヴン・マンスス

- ペイミグ

- バロウ・サインズ

- ニュー・ディフィニションズ

- ニュー・ライフ・オールウェイズ・アナウンシズ・イットセルフ・スルー・サウンド

- ハウ・ウィル・ゼイ・トーク*

*=日本盤ボーナス・トラック

Musician:アンディ・トーマ(prog、all)、ヤン・エスティー・ヴァーナー(prog、all)、ドド・ンキシ(ds)、トゥンデ・アリババ(perc)、drumno(ds)、ルイス・シュデ=ソケイ(voice、text)、ヤムア・ウツコンカヤ(voice)、エリック・D・クラーク(loose tool)

Producer:マウス・オン・マーズ

Engineer:アンディ・トーマ、ヤン・エスティー・ヴァーナー

Studio:Paraverse