マスタリング・エンジニアの粟飯原友美氏が、一個人としてイマーシブ作品の企画からリリースまでをプロデュースするという意欲的な試みを敢行した。しかも、イマーシブ・フォーマットはDolby Atmosとソニー 360 Reality Audioの2種類。楽曲はヤニス・クセナキスの打楽器曲「Rebonds(ルボン)」で、演奏は藤本隆文氏が担当した。レコーディングとミキシングは東京藝術大学 音楽学部 音楽環境創造科の教授であり、サラウンド研究の第一人者でもある亀川徹氏が手掛け、そのサポートにはDolby Atmos作品の制作経験が豊富なレコーディング・エンジニアの篠原麻梨氏が参加。本インタビューでは粟飯原氏に加えて、亀川氏と篠原氏にもご同席を願い、ミックスが行われた東京藝術大学 千住キャンパスのスタジオBにてお話を伺った。

Photo:Takashi Yashima(メイン写真&千住キャンパス スタジオB)

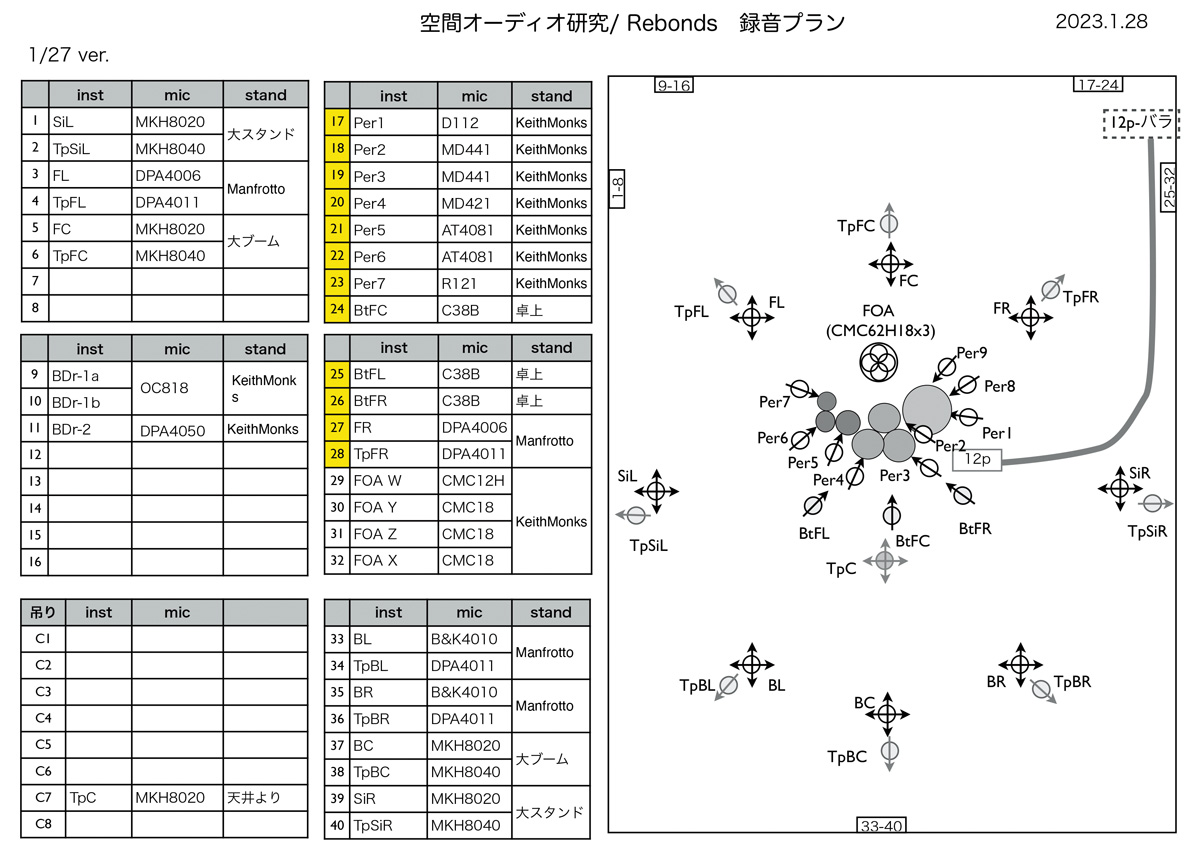

27.2chを想定したマイキングでレコーディング

——今回のプロジェクトを立ち上げたきっかけから教えていただけますか?

粟飯原 Dolby Atmosに関しては、一昨年、昨年とマスタリング・エンジニアとして関わらせていただく機会があったものの、それほど数が増えていく感じはしませんでした。そこで自分で仕事を作ってしまおうと思ったのがきっかけです。また、どうせなら同じ楽曲でDolby Atmosと360 Reality Audioの両方をリリースして、配信まで自分で行うことで収益的な面まで知ることができたら、とも思ったんです。そこで、以前からお付き合いのあったSONAの染谷和孝さんにご相談したところ、亀川(徹)先生をご紹介いただきました。染谷さんは東京藝術大学 音楽環境創造科で非常勤講師をされているので、亀川先生とも交流があったんです。

——楽曲のセレクトはどのように?

粟飯原 亀川先生から、“こんな曲が面白いんじゃないですか?”と候補を幾つか挙げていただいて、篠原さんと一緒にどれがいいかを考えていったときに、2人の意見が一致したのが「Rebonds」でした。

亀川 当初はオーケストラのような大きな編成で、というお話もあったのですが、初めてイマーシブをイチから手掛けるとしたら少し冒険かもしれないということで、もう少し小編成のアンサンブルで考えませんか?というご相談を粟飯原さんとしました。それで最終的に「Rebonds」に決まったという経緯です。イマーシブ的にも面白い表現ができそうな曲ですし、演奏者は1人なので、東京藝術大学 千住キャンパスのスタジオAで録音できる規模ということで、私としてもハンドリングしやすいというメリットもありました。

——レコーディングはどのようなコンセプトで?

粟飯原 亀川先生にDolby Atmosと360 Reality Audioの両方を作りたいとご相談した際、“リリースという形は取れないけれども、22.2chでも録ってみたいです”というご相談もさせていただきました。

亀川 ミックスを行ったこのスタジオBは現在、27.2chのシステムが組まれているのですが、本曲の録音当時は22.2chの環境でした。Dolby Atmosの7.1.4chや360 Reality Audioでよく使われる上層5ch、中層5ch、下層3chというスピーカー配置は、22.2chで作っておけば、後は減らしていく方向で進めればよいので問題はないだろうと思っていたんです。最終的にはリスナーを360度取り囲むように下層も8chにしたので、正確には27.2chで再生できるように作っています。

篠原 私はDolby Atmosの制作経験しかなく、今回360 Reality Audioを体験できたのはとても学びになりましたし、22.2chはセミナーでしか聴いたことがなかったので、そのレコーディングのお手伝いができたことはすごく貴重なことでした。

——マイキングに際しては、リスナーと楽器の位置関係をどのように想定されたのでしょうか?

亀川 これにはいろいろなパターンが考えられると思うのですが、今回は粟飯原さんと相談の上、リスナーが演奏者の位置にいて、自分の周りを楽器が取り囲んでいるという聴こえ方にしました。

粟飯原 「Rebonds」には「a」と「b」という2つの楽章があり、使用される楽器も多少違うのですが、「a」であれば左にグランカッサ、正面にタムが3つ、そして右にコンガとボンゴという配置です。「b」の場合はタムが1つになるのでやや正面にコンガがあり、一番右に木柾という楽器が置かれています。この演奏者から見た楽器配置をミックスでも再現していただきました。特に360 Reality Audioでは楽器の音に包み込まれるような空間作りを行いたかったので、そのイメージで亀川先生にマイキングを依頼しています。

——マイキングとしては、各楽器用のオンマイクのほかに、楽器を取り囲んでいるオフマイクもありますね。

亀川 中層用に全指向を8本、上層用と下層用に単一指向を8本、楽器を取り囲むように並べました。下層用は360 Reality Audio版を作るためのものです。中層と上層だけだと、音像が上がってしまいがちなのですが、下層があることで上下のバランスを取りやすくなります。ですから、360 Reality Audioは上下間の位置関係を作りやすいですね。

——各層の高さはどれくらいに設定されたのでしょう?

亀川 中層用は2mくらいで、上層用は4mくらいです。各層のマイクの指向性については、いろいろな考え方があるのですが、低周波が多く入りやすい全指向を上層や下層に使用すると、チャンネルが多いときに低周波同士の干渉が起きることがあります。そこで上層と下層には単一を使いました。また上層のマイクは楽器と反対側の外向きにしたのですが、下層はいろいろ試してみた結果、楽器側へ向けました。ですから、ある意味スポット的な使い方になっていて、最終的には低音を補強するようなマイキングになりました。

——レコーディングのルーティングは?

亀川 マイクからスタジオAに隣接する録音調整室の卓、ADT AUDIO SRC51のヘッド・アンプに入力して、そこからAVID Pro Toolsに録っています。モニターはPro Toolsの出力を5chサラウンドにミックスして聴いていました。同時に、スタジオBでは27chでモニタリングできるようにもしました。EQやコンプなどはほぼ使わず、何か問題があったら、マイクの位置で解決するというのが基本的な考え方です。

篠原 私はマイク・チェックくらいまでは5chでモニターしていたのですが、録りはじめてからはスタジオBでモニターさせていただきました。仕上がりをイメージしやすい環境だったので、録音に参加されていた特別研究員のウィル・ハーウィさんと一緒に、このマイクはもう少し近づけたほうがいいねとか、低音の回り込みを再現するためにマイクを増やそうかといったアイディアを出し合い、とても盛り上がりました。

亀川 録音では、どうしてもスポット・マイクを中心に聴くことになるわけですが、篠原さんたちにスタジオBで空間を録っているマイクをモニターしていただけたので、“このマイクをもう少し動かしたほうがいい”とか、あるいは“マイクを足した方がいいのでは?”というアドバイスをいただけたのは、とてもよかったですね。

——演奏された藤本隆文さんは、東京藝術大学 音楽学部 器楽科の教授でもありますが、どのような感想を持たれていましたか?

亀川 藤本先生とは以前にも何度か、3Dオーディオの作品をご一緒していたので、今回も喜んで協力していただけました。打楽器でこうした作品にふさわしい面白い曲はいっぱいあるよって教えていただけて、すごく楽しんでいただけましたね。

各フォーマットの特性に合わせたミックス

——ミックスはどちらのイマーシブ・フォーマットから着手されたのですか?

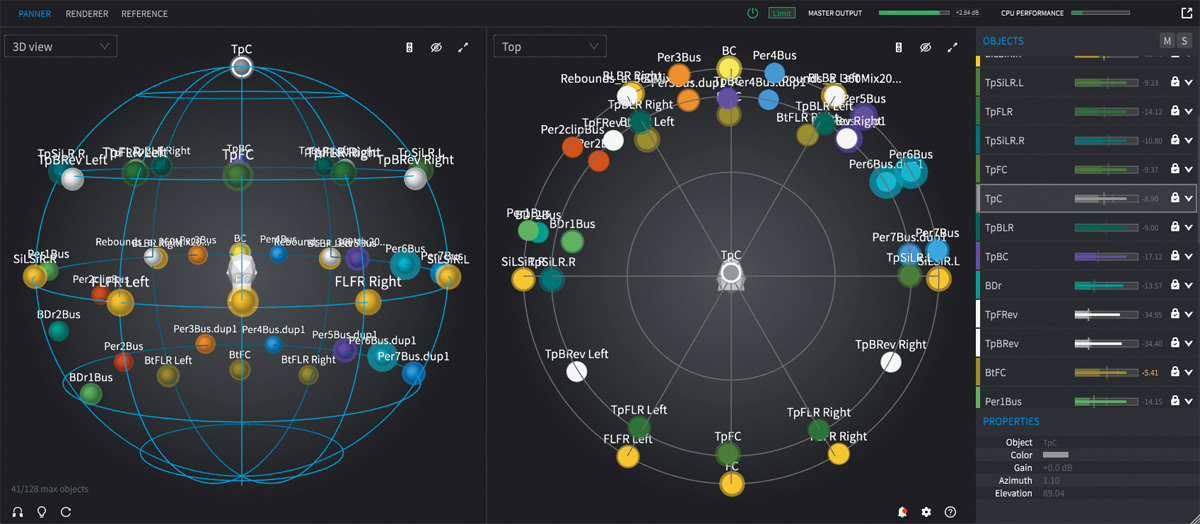

亀川 最初に27.2chのミックスをCOCKOS Reaperで作り、それをDolby Atmos用にPro Toolsへ置き換えていきました。27chを7.1.4chへどのように割り振りし直すかについては、例えば、7.1.4chにバック・センターはないので、それを後ろの両側に送るといったことを行うわけですが、問題だったのは上層を4chにしなければいけないことと、ボトムがなくなるのをどうするかということでした。基本はボトムを中層において、トップの8chをそれぞれの方向を保つように4chに振り分けていくということにしつつ、それで“ちょっと違うかな?”となったら、このマイクのレベルは下げようとか、あるいはやめてしまいましょうという具合に調整していきました。だから、中層の7.1chはベッド、上層はオブジェクトで4chを作りつつも、全体としては極めてチャンネル・ベース的な考え方でミックスしています。オブジェクトと言っても、楽器を動かすということも最終的にはなくていいかなということになりました。

粟飯原 「b」で登場する木柾という楽器だけ、最初は少し動かしてみようかという案も出たのですが、クラシックで楽器が動くことに違和感を覚える人もいるかもしれないと考えて、オーソドックスに動かさない方向にしました。

篠原 ちなみに、木柾に関してはクセナキスのスコアでは本来ウッド・ブロックなんですが、音のレンジを広げる意図で、通常のウッド・ブロックよりピッチの高い木柾を使用しています。「a」に関しては本来ハイタムを使用するところを、あえて音色のつながりを意識してコンガに置き換えていたり、どちらもクセナキスの意図を考察した上での藤本さんの楽器アレンジなので、その辺りも今作の聴き所の一つだと思います。

——360 Reality Audioのミックスは、Dolby Atmosとは違うアプローチを採られたのでしょうか?

亀川 やはりフォーマットが異なりますし、360 Reality Audio最大のメリットは下層があることだと思っているので、そこをきちんと使ったミックスをしようということになりました。楽器の配置自体はそれほど大きく変わらないのですが、上下の表現に関しては、360 Reality Audioのほうがうまくいっているのではないかと思います。

粟飯原 正直、360 Reality Audioは未知の世界だったのですが、勉強していく中で、360 Reality Audioは位置させる場所で音のニュアンスが変わるということを知って、それをうまく生かしたいなと考えました。例えば、グランカッサのように低音感が出るものは、少し下にも配置すると、ちゃんと下にもいるなという感じが出てくるんですよね。そういう意味では、360 Reality Audioは直感的に楽器を配置していきやすいのかもしれないです。

——Dolby Atmosと360 Reality Audioのミックスにおける手順的な違いとしては、やはりDolby Atmos Rendererを使うか、AUDIO FUTURE 360 WalkMix Creatorを使うか、というところでしょうか?

亀川 そうですね。EQやリバーブなどの音作りをPro Tools上で行っているのは共通していて、Dolby Atmosでは7.1.4chを作ってDolby Atmos Rendererに送っている、360 Reality Audioでは各トラックに360 WalkMix Creatorをインサートしている、ということですね。360 Reality Audioでは、同じ楽器を上と下に置いてみるとよいのでは?という粟飯原さんのアイディアで、下層用にバスを足して組み直したりもしました。

マスタリングでは奥行き感をプラス

——マスタリングではどのような作業を?

粟飯原 今回はミックスをすごく良い形でフィックスしていただいたので、それを生かす方向でマスタリングしてみました。空間的に、奥行き感を少しプラスするような調整ですね。EQはFABFILTER Pro-Q 3で28kHz辺りを少しブーストして伸びを足したり、PLUGIN ALLIANCE Bettermaker EQ 232Dで低音の質感を調整したりといったことを行いました。

——Dolby AtmosではレンダリングしたものをPro Toolsに読み込んで処理を行っているのでしょうか?

篠原 はい。Dolby Atmos Rendererでファイナル・ミックスを一度ADM BWFに書き出し、それをPro Toolsに読み込んで、粟飯原さんがマスタリングを行っています。その後、さらに.atmosマスターを作るという流れです。

粟飯原 ミックスしたPro Toolsのセッションで直接マスタリングを行ってもよかったのかもしれないですけど、プラグインの数も増えてしまいますし、ミックスした人と同じプラグインを持っている必要があることを考えると、分けたほうが自由度は増しますね。

——360 Reality Audioのほうは?

粟飯原 こちらはDolby Atmosのように各トラックをオーディオで書き出して、ということができないので、ミックスを行ったPro Toolsのセッションをそのまま使わせていただきました。そのため、ミックスの際も私が持っているプラグインのみに限定させていただきました。自宅ではバイノーラルでモニターしつつ、最終的にはこのスタジオBに持ち込んで最終調整を行っています。

——本プロジェクトを通じて、あらためて得られた気づきなどはありましたか?

粟飯原 Dolby Atmosはちょうどいい場所にすべての音が配置されている感じがして、聴いていて気持ち良かったですね。360 Reality Audioはやはり下層があるので、360 Reality Audioでしかできない表現があるなと思いました。

篠原 360 Reality Audioの下層部分を含めた球体の音場は没入感がありますし、オブジェクト・ベースなので音楽作品では直感的にクリエイティブな表現ができるなという印象を受けました。一方で、私自身が映像作品に関わることが多いのもあり、Dolby Atmosに関してはスクリーンありきの空間表現として、自然でストーリーや映像に寄り添うサウンド・メイクができる点などは、Dolby Atmosの良さだなと再確認しました。また今回は、亀川先生が27.2chを想定したマイキングをしてくださったことで、Dolby Atmosや360 Reality Audioというフォーマットの枠を感じさせないダイナミックな仕上がりになっていると感じています。

亀川 Dolby Atmosにしても、360 Reality Audioにしても、まだまだ検証が必要な部分はありますが、個人で制作してリリースまでできるというのは素晴らしいことだと思います。リリースされた音を早く聴いてみたいです。

——リリースに関してはどのような形で?

粟飯原 Dolby Atmosに関しては、AVIDの音楽配信ディストリビューション・サービスであるAvidPlayを通じてリリースします(編注:7月31日よりApple Musicにて配信開始。“Rebonds, Fujimoto”で検索してみてほしい)。360 Reality Audioに関しては、音楽配信サービスのプラットフォームTully Appを通じて、Amazon Musicでリリースする予定です。こちらもこの記事が掲載されたサンレコが発売されるころには聴けるはずですので、ぜひ検索してみてください。

Release

『Rebonds』

Takafumi Fujimoto

Producer:粟飯原友美

Engineer:亀川徹(レコーディング&ミックス)、粟飯原友美(マスタリング)

Studio:東京藝術大学 千住キャンパス スタジオA、スタジオB、録音調整室

●制作サポート:篠原麻梨

●Dolby Atmosテクニカル・アドバイザー:染谷和孝

●ソニー 360 Reality Audioテクニカルサポート:渡辺忠敏

●レコーディング・スタッフ(学年は2023年1月レコーディング当時):Will Howie(東京藝術大学 特別研究員)、池田翔(東京藝術大学 音楽環境創造科 4年生)、伊藤明日奈(東京藝術大学 音楽環境創造科 4年生)、Julius Johansson(東京藝術大学 音楽環境創造科 シベリウス音楽院からの留学生)、Hannes Baier(東京藝術大学 音楽環境創造科 ベルリン芸術大学からの留学生)

●楽器サポート:彌永和沙、岡田満里子

●機材協力(DPA 4055):ヒビノインターサウンド